Publié : 17 décembre 2025

Actualisé : 14 heures ago

Fiabilité : ✓ Sources vérifiées

Je mets à jour cet article dès que de nouvelles informations sont disponibles.

📋 Sommaire

- 📱 Mistral débarque sur iPhone : La promesse de l’IA locale

- 🤔 Performances et Limitations : Le diable est dans les détails

- 💰 Impact économique et chaîne de valeur

- 🔮 Projection et Risques

- ❓ Questions fréquentes

- Mistral sur iPhone, ça veut dire que j’ai une IA super puissante comme ChatGPT, mais sans internet ?

- Est-ce que ça bouffe beaucoup de batterie de faire tourner cette IA sur mon iPhone ?

- Si tout le monde utilise ce genre d’appli, est-ce que Google et les autres vont perdre de l’argent ?

L’idée d’avoir une intelligence artificielle complète dans sa poche, capable de fonctionner même en mode avion, a de quoi séduire. L’application française Locally AI rend cela possible en installant les modèles Mistral directement sur iPhone. Mais au-delà de la prouesse technique, est-ce réellement un game changer ? Mon analyse, en tant qu’observateur de longue date de l’IA, est plus nuancée : si l’innovation est indéniable, les limitations actuelles ne doivent pas être occultées.

📱 Mistral débarque sur iPhone : La promesse de l’IA locale

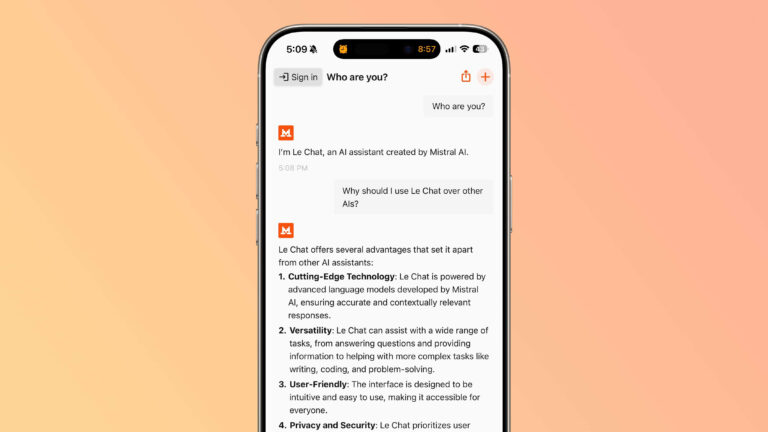

L’application Locally AI, développée par Adrien Grondin, permet désormais d’exécuter des modèles de langage (LLM) comme Mistral 3B directement sur iPhone. Fini le besoin de serveurs distants et l’inquiétude quant à la confidentialité des données : tout se passe en local. Une petite révolution, surtout quand on sait que même Apple ne propose pas cette fonctionnalité pour ses propres modèles.

L’article souligne que :

L’objectif est simple : disposer d’un modèle de langage dans la poche, sans envoi de données sur un serveur et accessible même en mode avion.

Ceci nous amène à examiner la perspective d’ingénierie. Faire tourner un modèle de 3 milliards de paramètres sur un smartphone est un défi technique considérable. Cela implique une optimisation poussée du modèle pour l’architecture mobile d’Apple, ainsi qu’une gestion rigoureuse de la mémoire et de la consommation d’énergie. Il faut dire que les derniers modèles d’iPhone sont équipés de puces puissantes, mais la puissance de calcul reste limitée par rapport à un serveur.

🤔 Performances et Limitations : Le diable est dans les détails

Si la possibilité d’exécuter Mistral 3B sur iPhone est impressionnante, il est crucial de comprendre les compromis. Le modèle 3B, bien que performant, est plus petit et moins précis que les modèles plus importants de Mistral AI. L’article mentionne d’ailleurs que ses réponses peuvent être inexactes. C’est un facteur d’échelle important : plus le modèle est petit, plus il est rapide et économe en ressources, mais moins il est performant.

Il faut aussi considérer les défis de l’inférence. L’inférence, c’est-à-dire le processus de génération de réponses par le modèle, est gourmande en ressources. Sur un iPhone, cela peut se traduire par des temps de réponse plus longs et une autonomie réduite. C’est un vecteur d’attaque potentiel : une application mal optimisée pourrait vider la batterie en quelques minutes.

Point Clé : L’exécution locale de modèles IA sur smartphone est une avancée prometteuse, mais les limitations en termes de précision et de performances sont à prendre en compte.

💰 Impact économique et chaîne de valeur

L’arrivée de l’IA locale sur smartphone pourrait bouleverser la chaîne de valeur de l’IA. Actuellement, la plupart des applications d’IA reposent sur des serveurs distants, souvent hébergés par des géants du cloud. Locally AI propose une alternative : une IA décentralisée, où le traitement se fait directement sur l’appareil de l’utilisateur. Cela pourrait favoriser l’émergence de nouveaux acteurs et réduire la dépendance aux grandes plateformes.

Or, c’est là que le bât blesse. Le coût de développement et d’optimisation de modèles pour l’exécution locale est élevé. De plus, la fragmentation du marché (différents modèles d’iPhone, différents systèmes d’exploitation) complexifie le travail des développeurs. Il faudra donc un modèle économique viable pour assurer la pérennité de cette approche.

🔮 Projection et Risques

Scénario Optimiste : Dans un avenir proche, les smartphones seront équipés de puces dédiées à l’IA, capables d’exécuter des modèles de langage complexes avec une efficacité énergétique optimale. Les applications d’IA locale se multiplieront, offrant des fonctionnalités innovantes dans des domaines tels que la traduction instantanée, la reconnaissance vocale et l’assistance personnelle. La confidentialité des données sera renforcée, car tout le traitement se fera sur l’appareil de l’utilisateur.

Scénario Pessimiste : L’IA locale restera une niche, limitée par les contraintes matérielles et les coûts de développement. Les modèles de langage les plus performants continueront d’être hébergés sur des serveurs distants, contrôlés par les géants du cloud. La fragmentation du marché et les problèmes de compatibilité freineront l’adoption de l’IA locale. De plus, des vulnérabilités de sécurité pourraient être découvertes dans les applications d’IA locale, compromettant la confidentialité des données des utilisateurs.

Un commentaire